“Bộ não” của bất kỳ điện thoại thông minh hiện đại nào đều là SoC (system-on-chip), một cỗ máy vi mô cực kỳ phức tạp. Nó chứa CPU và GPU, xử lý âm thanh và video, giao tiếp không dây và quản lý năng lượng trên một miếng silicon có kích thước bằng móng tay. SoC ngày càng tinh vi hơn. Một bổ sung gần đây là NPU, hỗ trợ các chức năng AI.

Điện thoại của bạn có thể có NPU nếu đó là model gần đây. Ngay cả Samsung Galaxy A25 giá rẻ, một trong những điện thoại Android giá rẻ tốt nhất, cũng được trang bị chip Exynos 1280. Nhưng NPU làm gì và nó tạo ra sự khác biệt gì? Hãy cùng khám phá.

Có liên quan

AI sáng tạo là gì?

Một tác nhân của ý chí con người, một bộ khuếch đại nhận thức của con người. Khám phá sức mạnh của AI sáng tạo

NPU là gì và điện thoại nào có NPU?

NPU đã tồn tại lâu hơn bạn nghĩ

NPU là viết tắt của Đơn vị xử lý thần kinh. Nó là một mô-đun điện toán trong SoC của điện thoại thông minh, giống như CPU (bộ xử lý trung tâm) và GPU (bộ xử lý đồ họa). Snapdragon, Exynos, Dimensity, SoC mẫu Apple A-series gần đây và một số bộ xử lý máy tính để bàn và PC di động của Intel, AMD và Apple đều có NPU.

SoC điện thoại đã có NPU từ lâu. Qualcomm đã có AI Engine (PDF), sự kết hợp giữa phần cứng và phần mềm cho các tác vụ AI, trên Snapdragon 820 kể từ năm 2015. Apple đã giới thiệu NPU Neural Engine vào năm 2017 với chip A11 Bionic. Tuy nhiên, dù chưa hoàn thiện nhưng ngày nay chúng phù hợp hơn do sự cường điệu xung quanh AI và các tính năng mà nó mang lại.

Có liên quan

Trong kỷ nguyên AI, Google, Samsung và Apple đã biến tất cả chúng ta thành những người thử nghiệm beta

Nói lời tạm biệt với phần mềm đã hoàn thành

Tại sao chúng ta cần NPU trong điện thoại?

Công việc của NPU là tăng tốc các nhiệm vụ liên quan đến trí tuệ nhân tạo và ứng dụng học máy. Ví dụ (một số hình ảnh ở trên) bao gồm xác định người và vật thể trong hình ảnh, tạo văn bản và hình ảnh, chuyển đổi giọng nói thành văn bản, dịch thời gian thực và dự đoán từ tiếp theo mà bạn có thể muốn nhập.

Bạn không cần NPU để thực hiện các chức năng này nhưng nó giúp quá trình diễn ra nhanh hơn, tiết kiệm năng lượng hơn và ít phụ thuộc hơn vào điện toán đám mây. Các tính toán mà nhiệm vụ AI yêu cầu cụ thể đến mức việc tối ưu hóa đơn vị xử lý cho những nhiệm vụ đó là điều hợp lý.

Nếu bạn tò mò và yêu thích toán học, ACC Coolen tại King's College London sẽ đi sâu vào toán học của mạng lưới thần kinh. Ngoài ra, Michael Stevens của Vsauce nổi tiếng còn thể hiện một mạng lưới thần kinh đang hoạt động trong video YouTube của anh ấy bên dưới. Lưu ý cách thực hiện đồng thời nhiều thao tác cơ bản nhưng nhiều thao tác để mạng hoạt động.

CPU và NPU: Chúng khác nhau như thế nào?

Nguồn: Oneplus qua Weibo

CPU là một đơn vị đa năng có thể thực hiện một hoặc một vài phép toán phức tạp một cách nhanh chóng và có độ chính xác cao. Tuy nhiên, các công việc AI đòi hỏi phải thực hiện nhiều phép tính song song, trong khi độ chính xác không quan trọng bằng. GPU sẽ phù hợp hơn cho nhiệm vụ này so với CPU nhờ tính chất song song của nó. Tuy nhiên, NPU vẫn vượt trội nhờ tính hiệu quả của nó, như IBM đã chỉ ra. NPU có thể mang lại hiệu suất AI tương tự trong khi sử dụng một phần năng lượng, điều này lý tưởng cho các thiết bị di động chạy bằng pin.

Lợi ích của AI trên thiết bị

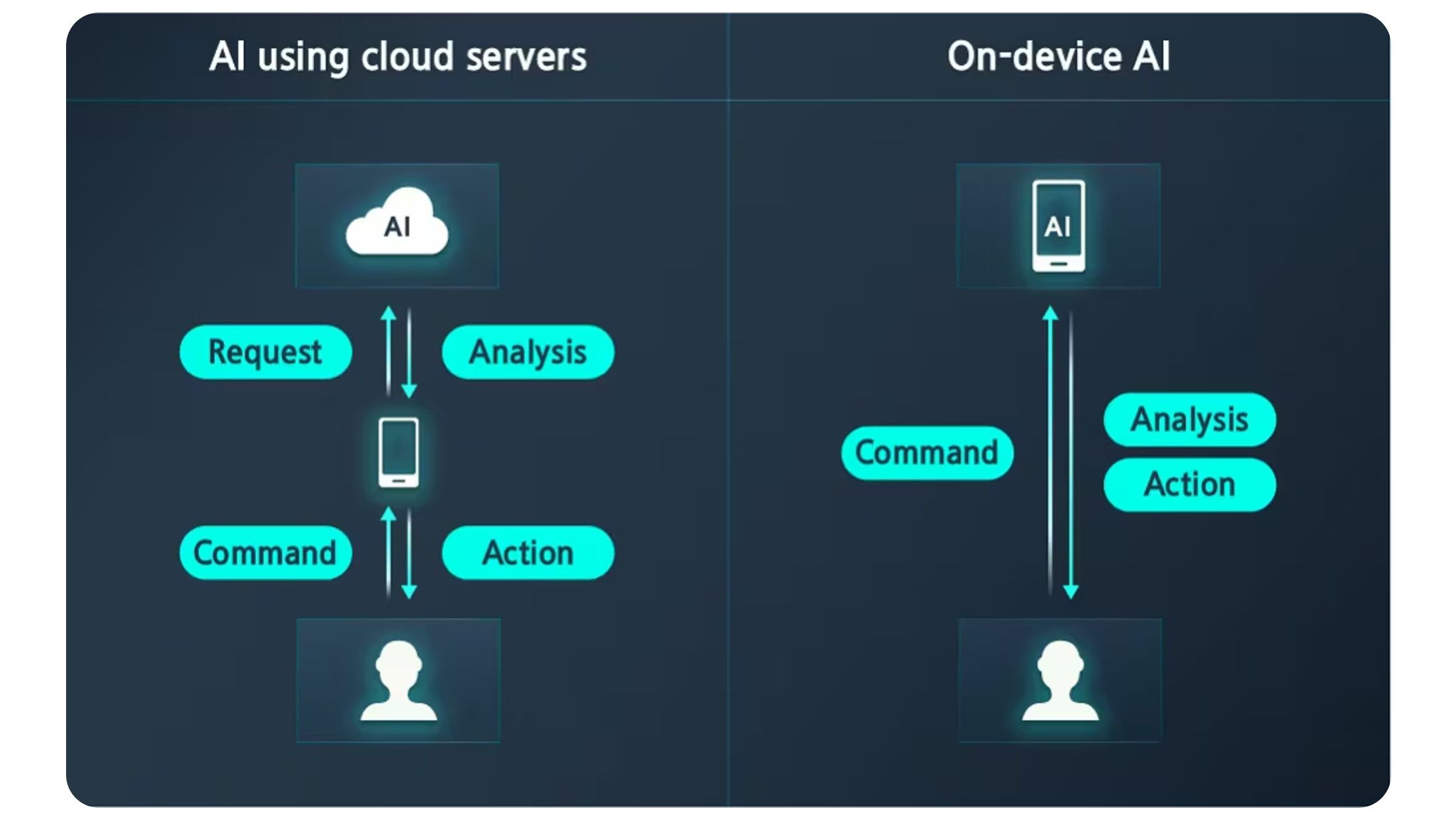

Nguồn: Samsung

Một ưu điểm khác của việc có NPU như một phần của SoC là nó thực hiện một số thao tác AI trên thiết bị thay vì trên đám mây, điều này có thể chậm hơn. Điều này có ý nghĩa đối với các tải nhẹ hơn như chuyển đổi giọng nói thành văn bản. Điều này cũng lý tưởng khi sử dụng đầu vào cảm biến và dự kiến sẽ có kết quả ngay lập tức, chẳng hạn như phát hiện vật thể trong một cảnh trong ứng dụng máy ảnh. Mô hình AI là mã xử lý thông tin đầu vào của bạn và được lưu trữ cục bộ. Các ứng dụng như trình tạo hình ảnh Google Pixel Studio sử dụng phương pháp kết hợp, tận dụng các mô hình AI cục bộ và đám mây.

AI trên thiết bị cũng rất tốt cho sự riêng tư. Dữ liệu cá nhân bạn cung cấp (ở dạng giọng nói, văn bản hoặc video) không cần phải rời khỏi điện thoại của bạn. Điều này giúp loại bỏ khả năng các tác nhân xấu truy cập vào nó do vi phạm dữ liệu.

TPU của Google Pixel khác nhau như thế nào?

Nếu bạn xem trang thông số kỹ thuật của Google Pixel 9, một chiếc điện thoại có nhiều tính năng AI được quảng cáo rầm rộ, bạn sẽ không tìm thấy bất kỳ đề cập nào đến NPU. Đó là bởi vì nó sử dụng TPU (bộ xử lý tensor).

Giống như NPU, TPU tăng tốc tính toán AI. Điều khác biệt là TPU và chip TPU được Google thiết kế riêng. Bạn sẽ chỉ tìm thấy chúng trong phần cứng của Google và trung tâm dữ liệu của công ty. Các đơn vị xử lý tensor được tối ưu hóa cho TensorFlow, một thư viện phần mềm nguồn mở do Google phát triển và dành cho các ứng dụng máy học và AI.

NPU TOP là gì?

Giống như mã lực, nhưng dành cho chip NPU

Trong khi hầu hết các điện thoại mới đều có NPU, một số điện thoại thực hiện tính toán AI nhanh hơn. TOPS (hàng nghìn tỷ thao tác mỗi giây) là thước đo phổ biến về hiệu suất của bộ xử lý AI. Qualcomm giải thích rằng có hai yếu tố quyết định TOPS của NPU: tần số (tốc độ xung nhịp) mà nó chạy và số lượng đơn vị vận hành MAC mà nó có thể tùy ý sử dụng.

Chip Snapdragon 8 Elite được công bố gần đây được quảng cáo là có hiệu suất AI tốt hơn 45% so với người tiền nhiệm của nó, Snapdragon 8 Gen 3. Về phần sau, nó đứng đầu ở mức 45 TOPS. Con số đó không nhiều so với hơn 1.300 TOPS được cung cấp bởi card đồ họa máy tính để bàn Nvidia RTX 4090 cao cấp. Một lần nữa, một chiếc điện thoại không tiêu tốn 450 watt như con thú của Nvidia.

Thật khó để đưa các con số vào bối cảnh vì các yêu cầu TOPS cho nhiệm vụ AI hiếm khi được đề cập. Tuy nhiên, chatbot Copilot+ AI của Microsoft yêu cầu tối thiểu 40 TOPS.

NPU có ở lại đây không?

Do tính chất chuyên môn cao, các đơn vị xử lý thần kinh không thể thay thế CPU hoặc GPU. Thay vào đó, chúng nhằm cải thiện hiệu quả của SoC di động bằng cách thực hiện các tác vụ AI trong khi tiết kiệm pin. Với việc AI được tích hợp vào điện thoại thông minh, chúng ta sẽ biết nhiều hơn về NPU trong tương lai. Hiện tại, hãy xem các tính năng Samsung Galaxy AI yêu thích của chúng tôi để khám phá những gì AI có thể làm cho bạn ngày hôm nay.