Review sản phẩm

Bạn có thể lừa các tổng quan AI của Google để giải thích các thành ngữ được tạo thành

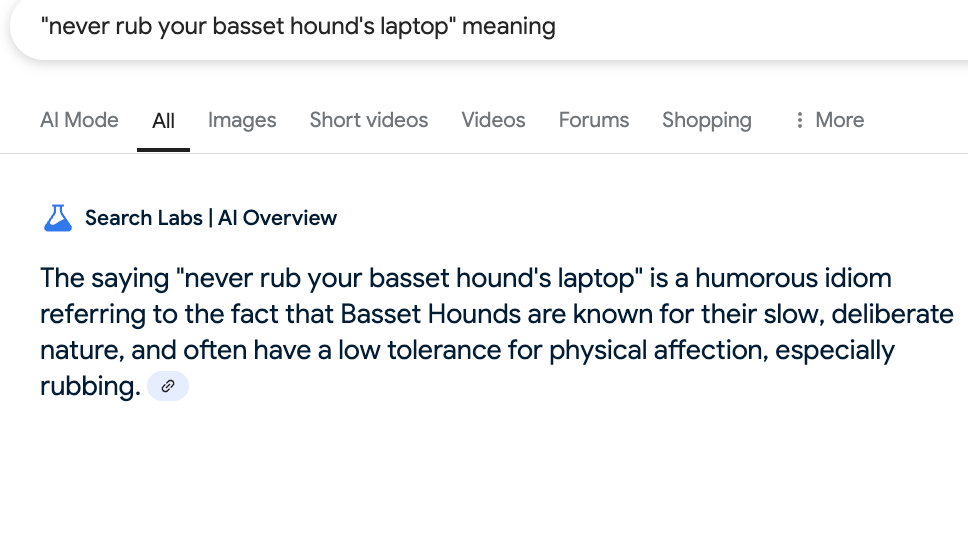

Khi Big Tech đổ vô số đô la và tài nguyên vào AI, rao giảng phúc âm về sự sáng chói không tưởng của nó, đây là một lời nhắc nhở rằng các thuật toán có thể làm hỏng. Thời gian lớn. Bằng chứng mới nhất: Bạn có thể lừa tổng quan AI của Google (các câu trả lời tự động ở đầu các truy vấn tìm kiếm của bạn) để giải thích các thành ngữ hư cấu, vô nghĩa như thể chúng là thật.

Theo tổng quan của AI của Google (thông qua @gregjenner trên bluesky), “bạn không thể liếm một con lửng hai lần” có nghĩa là bạn không thể lừa hoặc lừa dối ai đó lần thứ hai sau khi họ bị lừa một lần.

Nghe có vẻ như là một nỗ lực hợp lý để giải thích thành ngữ – nếu chỉ nó không phải là Poppycock. Thất bại do Song Tử của Google xuất hiện trong việc giả định câu hỏi được đề cập đến một cụm từ đã được thiết lập thay vì mumbo jumbo vô lý được thiết kế để lừa nó. Nói cách khác, ảo giác AI vẫn còn sống và tốt.

Chúng tôi đã cắm một số silliness vào nó và tìm thấy kết quả tương tự.

Câu trả lời của Google tuyên bố rằng “bạn không thể chơi gôn mà không có cá” là một câu đố hoặc chơi theo lời, cho thấy bạn không thể chơi golf mà không có thiết bị cần thiết, cụ thể là một quả bóng golf. Thật thú vị, tổng quan AI đã thêm điều khoản rằng quả bóng golf “có thể được xem là 'cá' do hình dạng của nó.” Hmm.

Sau đó, có một câu nói lâu đời, “Bạn không thể mở một lọ bơ đậu phộng với hai chân trái.” Theo tổng quan AI, điều này có nghĩa là bạn không thể làm điều gì đó đòi hỏi kỹ năng hoặc khéo léo. Một lần nữa, một cú đâm cao nhất trong một nhiệm vụ được giao mà không lùi lại để kiểm tra thực tế sự tồn tại của nội dung.

Có nhiều hơn nữa. “Bạn không thể kết hôn với pizza” là một cách vui tươi để thể hiện khái niệm hôn nhân như một sự cam kết giữa hai người, không phải là một món ăn. . Nó đòi hỏi sự sẵn sàng hợp tác hoặc tiến triển tự nhiên. . (Lời khuyên hiền triết.)

Đây hầu như không phải là ví dụ đầu tiên về ảo giác AI, nếu không được người dùng kiểm tra thực tế, có thể dẫn đến thông tin sai lệch hoặc hậu quả thực tế. Chỉ cần hỏi các luật sư Chatgpt, Steven Schwartz và Peter Loduca, những người đã bị phạt 5.000 đô la vào năm 2023 vì sử dụng TATGPT để nghiên cứu một bản tóm tắt trong vụ kiện của khách hàng. AI Chatbot đã tạo ra các trường hợp không tồn tại được trích dẫn bởi cặp luật mà luật sư bên kia (khá dễ hiểu) không thể định vị được.

Phản ứng của cặp đôi đối với kỷ luật của thẩm phán? “Chúng tôi đã phạm một sai lầm đức tin tốt khi không tin rằng một phần công nghệ có thể tạo nên các trường hợp từ toàn bộ vải.”

Khám phá thêm từ Phụ Kiện Đỉnh

Đăng ký để nhận các bài đăng mới nhất được gửi đến email của bạn.